集中式存储高可用

集中式存储高可用概述

传统SAN/NAS存储的硬件架构采用“控制器+硬盘柜”的方式。中高端存储支持多个控制器,以保障高可用并提高性能。多控制器为紧耦合,通过PCIE总线或Infiniband网络互连,共享磁盘阵列,共享缓存。

传统存储的系统架构具有I/O路径短,访问延迟小的优势。

传统存储通过内置BBU电池或外置的UPS来实现掉电保护,保障缓存中的数据在掉电后不丢失,结合双活、容灾、CDP等技术保障业务系统的连续性和数据安全性,传统集中式存储起步早,技术成熟,架构简单,表现出足够的稳定性,对高IOPS、低延时、和数据强一致性有很好支持。

另外,近年来全闪存阵列存储发展迅速,IOPS性能提高到机械硬盘存储的100倍以上,能够有效解决IOPS性能痛点,传统集中式存储的特性适合作为金融/医疗等核心业务系统的数据库存储。

- FC SAN:采用光纤通道(Fibre Channel,FC)技术,通过光纤通道交换机连接存储阵列和服务器主机,建立专用于数据存储的区域网络。

- IP SAN:基于以太网技术的存储网络。iSCSI(互联网小型计算机系统接口)是一种在TCP/IP上进行数据块传输的标准,可以实现在IP网络上运行SCSI协议,使其能够在高速以太网上进行快速的数据存取备份操作 。

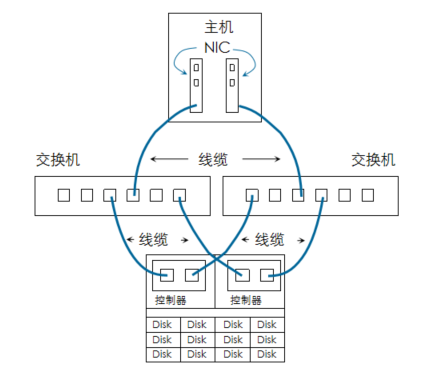

- 存储硬件冗余:几乎所有的硬件都有冗余,所以当部分硬件故障时,仍然至少会有一条从主机到存储设备的路径可用。

- 多路径:物理机到存储设备的LUN中存在多条活动路径,冗余路径提供了可靠性并告知系统多条路径识别到的是同一块磁盘。

多路径软件功能

- 最优路径选择:选择多条路径中的最佳的路径进行操作,能获取最佳的性能。

- 路径I/O负载均衡:自动选择多条路径进行下发,提高IO性能,以及根据路径繁忙程度进行业务路径选择。

- 故障倒换:业务链路发生故障的时候,故障倒换随之发生,实现业务不中断。

- 故障恢复:故障倒换之前的业务链路恢复后,业务恢复随之发生,用户无需介入,自动完成,且业务不中断。

多路径配置

- centos默认多路径配置:

defaults {

find_multipaths yes

user_friendly_names yes

}

blacklist {

}

devices {

device {

features 0

no_path_retry fail

product *

vendor *

}

}

- 浪潮多路径配置

1. 在/etc/multipath.conf 的 devices{}配置单元中,增加以下配置信息。

devices{

device {

vendor "INSPUR"

product "MCS"

path_grouping_policy group_by_prio

path_selector "round-robin 0"

features “1 queue_if_no_path”

prio alua

path_checker tur

failback immediate

no_path_retry “60”

rr_min_io 1

dev_loss_tmo 120

fast_io_fail_tmo 5

} }

2. 以上配置项中,path_selector 设置路径选择策略为 round-robin,即路径组中轮循使用路径,在其他配置信息中,若 path_selector 设置路径选择策略为 service time,则是最优路径组中轮循使用路径。如果需要在所有路径(最优路径组+非最优路径组) 中使用负载均衡策略,请修改该配置项的值:

path_grouping_policy multibus

- 请确保 multipath.conf 配置文件中,blacklist{} 配置项没有设置对阵列的屏蔽。即:

blacklist{

devnode “*”

}

- 需要将屏蔽设置注释掉,或者在 blacklist_exceptions{} 配置项中设置屏蔽例外。

3. 重启多路径服务,执行以下命令,重新加载配置。

systemctl reload multipathd.service

4. 检验配置是否生效,请执行以下命令:

multipath –ll

- 如果结果中输出存储的多路径拓扑,那么表示配置生效;若没有输出存储的多路径拓扑,表示配置没有生效,请检查系统日志文件或 multipath 命令的前台输出信息。